Mi az a ChatGPT?

A különleges chatbot lényegében véve olyan, mint egy továbbfejlesztett Google-kereső: az internet szinte teljes tudásanyagát felhasználva ad választ feltett kérdéseinkre, de nem találatokat dob ki, hanem szépen megfogalmazott szöveget ad. Nem keresőszavakkal kell kommunikálnunk vele, hanem feltehetjük pontosan azt a kérdést, ami minket érdekel. Előnye, hogy rögtön választ kapunk, vagyis a keresővel ellentétben itt nem kell a találatok közül válogatnunk, azokban kisebb-nagyobb mértékben elmélyednünk. Ha pedig hiányosnak érezzük a feleletet, tovább kérdezünk,

mintha egy olyan, nagyon okos emberrel beszélgetnénk, akinek a fejében megvan az emberiség minden eddigi tudása – legalábbis az, amit már felraktunk a netre.

Csakhogy korántsem biztos, hogy a megfelelő információkat fogja felkínálni nekünk ebből a végtelen tudásból.

„Gyorsabban kapunk választ, de csak olyan jól strukturált kérdésekre, amelyek esetében már léteznek viszonylag elfogadottnak mondható, letisztult és sokszor használt szövegállományok. Előzmény nélküli jelentéskombinációkra épülő probléma esetén már a kérdést sem fogja érteni a program. Ez hasonlít arra, amikor Hankiss Elemér, kiváló néhai kollégánk azt gépelte be egyszer az internetes keresőbe, »Mi az élet értelme?«, és szomorúan állapította meg, hogy nem kapott értékelhető találatot – pedig a program becsületesen szállította neki az összes olyan előfordulást, ahol ugyanez a szókapcsolat szerepelt sokat olvasott szövegekben. Az univerzális és túlzó várakozásokhoz képest továbbra is az az igazi kihívás, hogy minél több keresési problémáink minél több altípusához legyen illeszkedő, hatékony eszköz” – szögezi le Z. Karvalics László.Tehát a ChatGPT által adott válaszokat mindenképp ellenőrizni szükséges.

Z. Karvalics László az információs viselkedés evolúciós történetét és jelenkorát kutatja, a BME Információs Társadalom és Trendkutató Központjának alapítója, korábbi igazgatója volt. A BME és a Szegedi Tudományegyetem témába vágó tanszékeit is vezette, jelenleg pedig a kőszegi Felsőbbfokú Tanulmányok Intézetének vezető kutatója.

Kreatív-e a ChatGPT?

A számítástechnika történelme során már többször felmerült a kérdés, hogy egy program lehet-e kreatív. Már korábban is volt rá példa, hogy verseket írattak különböző algoritmusokkal, és hiába végezték el a gépek a feladatot, kreatívak nem voltak. Ennek egyik magyarázata, hogy a gép nem is tud róla, hogyha egy tartalomnak sikerült többletjelentést adnia, a jelentést mi tulajdonítjuk a szövegnek. Ami ennél is fontosabb, hogy a programoknak ilyen többletadó szándéka nincs is. Ilyen szándéka csak az embernek van: a gépek nem maguktól írnak verseket, hanem mi írattatunk velük.

„Mindenféle mesterséges intelligencia rendszer érzéketlen a jelentésre. Nem érti a saját dolgát, csak csinálja. A számítástechnika továbbra is számolásműveletekre épül, és a ChatGPT sem tesz mást, minthogy óriási mennyiségű kódolt anyagon felismeri a kódok bizonyos együttállását, és az algoritmusai alapján ezeket az együttállásokat prezentálja nekünk. De ezeknek a számoknak a tartalmáról halvány sejtelme sincs, És nem is kell lennie ahhoz, hogy jól működjön. Nem jut magától olyan gondolatra, ami nincs a rendszerében, amit nem adtunk be neki, és nem képes az önálló problémafelvetésre sem, nem kezdeményez. A problémát, a kérdést mi adjuk neki. A kreativitás az, ha te egyáltalán felteszel egy kérdést, amit még senki nem tett fel soha. Egyelőre mi sem értjük teljesen, hogyan képes erre az emberi agy, következésképpen modellezni, reprodukálni sem tudjuk” – magyarázza Z. Karvalics László.

Úgy kell ezt elképzelni, mintha fognánk egy hatodikos gyereket, aki épp a vázlatírást tanulja, és ellenőrzésképpen megkérnénk, foglalja össze a Debreceni Egyetem Elméleti Fizikai Tanszékén született, Molekuláris rendszerekben előforduló degeneranciák topologikus tulajdonságának numerikus vizsgálata című szakdolgozatot. Valószínűleg tudna belőle valamilyen szinten használható vázlatot írni, de ettől még nem sok fogalma lenne az elméleti fizikáról.

Tehát az MI nem gondolkodik az élet értelmén, amikor választ ad rá.

Példák a ChatGPT használatára

A ChatGPT elég hatékony eszköz, ha jól használjuk, sokan írnak már például e-maileket a segítségével. Egy amerikai cég orvosai 33 százalékos csökkenésről számoltak be „a dokumentáció és a közvetett betegellátási feladatok elvégzéséhez szükséges idő tekintetében”. Sok segítséget kaphatunk az egészségügyben és a gyógyászatban, hiszen ott is hatalmas mennyiségű szöveges dokumentummal (adat, zárójelentés, betegséglefutások) kell dolgozni. Ezek szigorú nyelvi rendben vannak megfogalmazva, és ha ebben az állományban kérdezünk, képes lesz egy ilyen algoritmus releváns összefüggéseket felmutatni az orvosoknak, akiknek nem is lehet ekkora mennyiségű adat a fejében.

Természetesen nem fog tudni helyettük diagnosztizálni, de a folyamatot segítheti.

Ha felteszünk neki például egy ritka esetre vonatkozó kérdést, akkor végig tudja nézni nagyon rövid idő alatt az eddigi példák leírásait, és tud adni egy vagy több választ a konkrét kérdésünkre. Az már az orvos döntése, mit kezd az információval.

„Vannak olyan rutinszerű, monoton szövegfeladatok is, amelyeket hatékonyan nagy önállósággal vált ki a mesterséges intelligencia. Kész öntőformákkal, amibe csak tartalmat kell tölteni. Ilyenek a sportmérkőzések eredményeinek az összefoglalója, meteorológiai jelentések, földrengés-hírek, valutaárfolyamok, tőzsdei hírek írása. Jó is, hogy az ilyen szövegekkel bíbelődni kénytelen újságírók kenyerét elveszik az okos algoritmusok, hiszen értékes életidejüket szélesebb körű tájékozódásra és magasabb hozzáadott értékkel bíró szövegalkotó tevékenységre fordíthatják” – hűti le a szakember azokat, akik ijedeznek az újságíró robotoktól. Az újságírók miatt azért sem érdemes aggódni, mert szövegek legyártására akkor is szükség lesz, ha egy nap mindenki úgy ébred fel, hogy nem a kedvenc híroldalát nyitja meg, hanem megkérdezi a chatbotot, mi történt ma, majd elbeszélget vele az őt érdeklő hírekről. Ennek megvalósulásához kelleni fog azoknak a híreknek a szövege, amikből a chatbot dolgozik. S az is lehet,

néha szeretnénk olyasmit is olvasni, amire nem kérdezünk rá, mert nem is tudunk a létezéséről.

Mivel a ChatGPT alapszinten programozni is képes – használni a programnyelvet a megadott paraméterek szerint –, ki tud váltani bizonyos programozói feladatokat is. Az elemzések szerint a szakmák közül a legveszélyeztetettebbnek a marketing, a pénzügy és a technológia területekhez tartozó állások számítanak. A chatbot által írt, négyes értékelést kapó diploma is a világ egyik legnívósabb üzleti képzését nyújtó egyetemén, a Wharton University-n született. A program brillírozott a kódírásban és a jogi szaknyelv értelmezésében, ám egyszerű matematika feladványokat sokszor nem tudta megoldani. A négyest úgy érte el, hogy ezekben a kérdésekben segített neki egy humán szakértő. Az, hogy mégis négyest kapott, nyilván a professzorok lelkesedésének köszönhető.

Amikor a ChatGPT nem működik

A ChatGPT tesztelésében a sikeres és lenyűgöző eredmények sora mellett bőven van példa a rendszer nevetségessé tételére és kifigurázására is. „Nem megfelelő szerkezetű kérdéssel azonnal be lehet vinni a málnásba a robotot, ilyenkor hülyeséget fog válaszolni. Mi, emberek képesek vagyunk hülye kérdésre is értelmesen válaszolni. Persze, az is bőven előfordul, hogy okos kérdésre is hülyeséget válaszol az MI, illetve számos helyzettel nem tud mit kezdeni. Ha például azt kérdezem meg kutatóként, hogy egy szakszó milyen szakcikkekben, és mióta fordul elő, akkor arra tökéletesen válaszolni fog. De ha arra vagyok kíváncsi, ki vitatkozott egy ezzel kapcsolatban megjelenő állítással, akkor kiderül, hogy nem feltétlenül tudja felismerni a vitahelyzeteket. Korlátozottan igen, ha szerepelnek a szövegben a bírálat és a kritika szavak, de csak részben kategorizálhatóak azok a nyelvi megoldások, amelyek az ellenvéleményt kifejezik. Azt a kifejezést már nem fogja felismerni, mint a ’hajlok arra, hogy ne fogadjam el a tanult kollégám állítását’ stb. Korlátlan számban lehet legyártani az ilyen helyzeteket, amelyekben

József Attila szavaival szólva a törvény szövedéke mindig fölfeslik valahol, mert nem elég felismerni a szókapcsolatok jelenlétét, hanem érteni is kellene azokat.”

Maga a mesterséges intelligencia megfogalmazás is megtévesztő, ugyanis nem az intelligencia a sajátossága és újdonsága ezeknek az algoritmusoknak, hanem a tanulásra való képessége – ami valójában a gép esetében nem jelent mást, mint még nagyobb állományon még stabilabb beállításokkal végrehajtott műveleteket.

Minden pofonhoz rendőrt állítani nem lehet

A mesterséges intelligencia sok adatból tanul meg felismerni valamit, de önmagában nem elég, ha ráeresztjük ezekre az adatokra: ezeknek először mi adunk jelentést. Ha például egy cicák képét felismerni képes algoritmus kap egy halom kutyás adatbázist, nem fogja tudni megtanulni a kutyákat is felismerni, ameddig valaki meg nem mondjuk neki, hogy ezek kutyák. Ennek szemléletes és szomorú példája, hogy a chatbot betanításához szükséges volt a „sötét” tartalmakat címkézni, hiszen el kellett kerülni az erőszakos, illegális, toxikus szövegek beválogatását a válaszokba. Ezt olyan adatcímkézők végzik el, akik munkakörülményei Ázsiában és Afrikában sokféle kívánnivalót hagynak maguk után. Nemcsak kizsákmányolás (rendkívül alacsony fizetés) jellemzi, de traumatikus élmények előidézése is, hiszen ezeket a tartalmakat nekik el kell olvasniuk, hogy címkézhessék a mesterséges intelligencia számára. S ezek a szövegek erőszakos, pedofil, illegális cselekményeket írtak le. Sajnos, az emberi munka itt kikerülhetetlen volt.

„Rejtő Jenőtől tudok idézni, aki azt írta, nem lehet minden pofon mellé rendőrt állítani. Egy algoritmus esetében minden képződő variáció mellé oda kell rakni az élő emberi elmét, hogy megmondja a gépnek, mi a helyes kód. A túlzások és a rossz metaforák miatt sokak számára még mindig nem egyértelmű, hogy az MI is csak egy eszköz az ember kezében, nem önálló entitás. Mindig csak velünk összekapcsoltan működik. Így nem is az MI-től kell félni, hanem azoktól az emberektől, aki majd rosszra használják.

Tipikus hiba, hogy csak a gépi oldalra figyelünk, márpedig az ember és a gép hibridként működik”

– hívja fel a figyelmet Z. Karvalics László. Hozzáteszi: a ChatGPT a többi keresőhöz hasonlóan kidobhat rossz válaszokat, álhíreket, áltudományos tartalmakat.

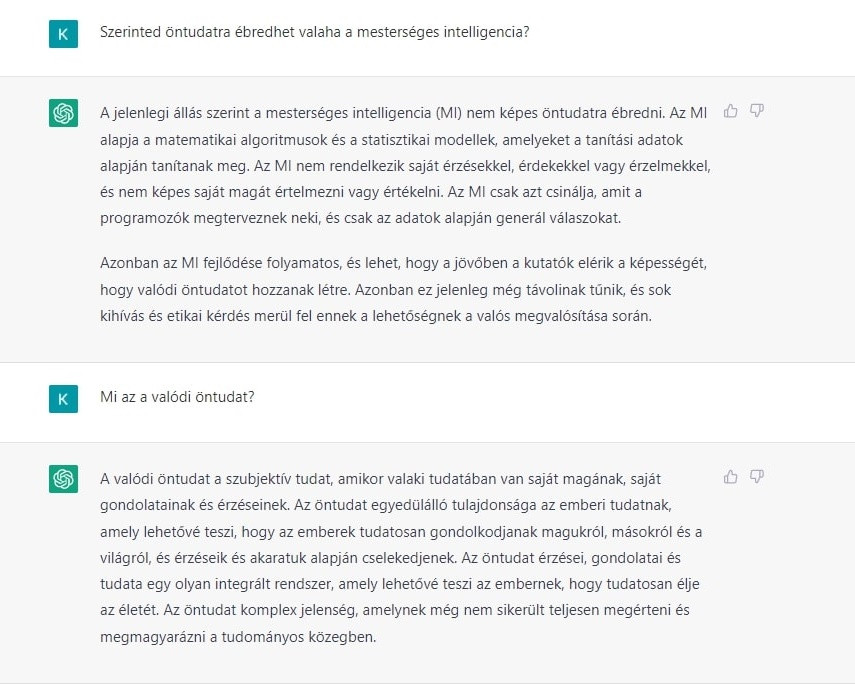

Chatbotok öntudatra ébredése

A természetes intelligencia számos képességből áll össze, a mesterséges intelligencia csak néhány területen képes jobban teljesíteni. Gondoljunk csak a számolásra magára. Már az első abakuszok óta használunk olyan eszközöket, amelyek révén jobb számolásteljesítményt érhetünk el, mint amire az emberi elme képes. De a sínen csúszkáló golyók nem intelligensek: mi vagyunk azok, akik teremtettük és használjuk őket.

Ha az MI-vel kapcsolatban történik valami, idővel mindig ugyanoda lyukadunk ki: öntudatra ébredhet-e gép, lehet-e okosabb az embernél, hogy uralja? A válasz pedig nagyon unalmas: nem. Ez hasonlóképpen lehetetlen számára, mint ahogy a valódi kreativitás is: az MI-nek nem jut eszébe olyasmit tenni, amit nem tápláltak bele, mint lehetőséget.

„Bizonyos értelemben egy amőba is intelligensebb az MI-nél, mert felméri a környezetét, és aszerint viselkedik, hogy kedvezőbb helyzetbe kerüljön. Ilyesmire – önálló problémaérzékelésre és ennek alapján cselekvésválasztás megindítására az MI nem képes. Az MI nem cselekszik, csak műveletet hajt végre. Ez nagyon fontos különbség” – foglalja össze a lényeget Z. Karvalics László.

Ajánljuk még:

„Ne dobj ki semmit!” – így öltöztek liszteszsákokból az amerikaiak a nagy világválság idején

„A hangadók lecsendesedtek, a visszahúzódók nyitottabbá váltak” – tapasztalataim a projektoktatásról

Gyerekeink jövője: milyen hatással lesz rá a mesterséges intelligencia?

A kreatív gyerek boldogabb gyerek – így segítheted a kibontakozását

Általánosan elterjedt nézet, hogy a kreativitás olyan jellemző, amellyel valaki vagy rendelkezik, vagy nem. Nem lehet kicsit kreatívnak lenni a közvélemény szerint – csakhogy ez alapvetően téves megközelítés, amivel igencsak sokat ártunk gyerekeinknek. Szerintem.